Узнайте больше о том, как мы добиваемся прогресса в выполнении наших обязательств в области устойчивого развития, в первой части этого блога: Устойчивость по замыслу: инновации для повышения энергоэффективности с помощью искусственного интеллекта, часть 1.

Продолжая выполнять свои обязательства перед клиентами в области облачных технологий и инноваций в области искусственного интеллекта, мы остаемся решительными в своем стремлении к повышению устойчивости. Важнейшей частью достижения цели нашей компании по снижению выбросов углекислого газа к 2030 году является переосмысление нашей облачной инфраструктуры и инфраструктуры искусственного интеллекта с уделением первостепенного внимания энергопотреблению и энергоэффективности.

Мы преследуем нашу цель по сокращению выбросов углерода, опираясь на три основных направления: сокращение выбросов углекислого газа, безуглеродное электричество и удаление углерода. В рамках сокращения выбросов углекислого газа энергоэффективность и энергоэффективность имеют основополагающее значение для прогресса в области устойчивого развития как для нашей компании, так и для отрасли в целом.

- Узнайте, как мы повышаем устойчивость ИИ

- Телеметрия мощности на уровне микросхем для получения точных данных об использовании в режиме реального времени.

- Совместная работа над развитием отраслевых стандартов для форматов данных ИИ.

- Повышение эффективности вывода LLM за счет разделения фазы

- Узнайте больше и изучите ресурсы для повышения эффективности ИИ

Узнайте, как мы повышаем устойчивость ИИ

Изучите три направления нашей деятельности

Хотя термины «мощность» и «энергия» обычно используются как взаимозаменяемые, энергоэффективность связана с управлением пиковыми нагрузками, тогда как энергоэффективность связана с уменьшением общего количества потребляемой энергии с течением времени.

Это различие становится важным для специфики исследований и применения из-за типа эффективности. В качестве примера энергоэффективности вы можете изучить малые языковые модели (SLM) с меньшим количеством параметров, которые могут выполняться локально на вашем телефоне, используя меньшую общую вычислительную мощность. Чтобы повысить энергоэффективность, вы можете искать способы улучшить использование доступной мощности за счет улучшения прогнозирования требований рабочей нагрузки.

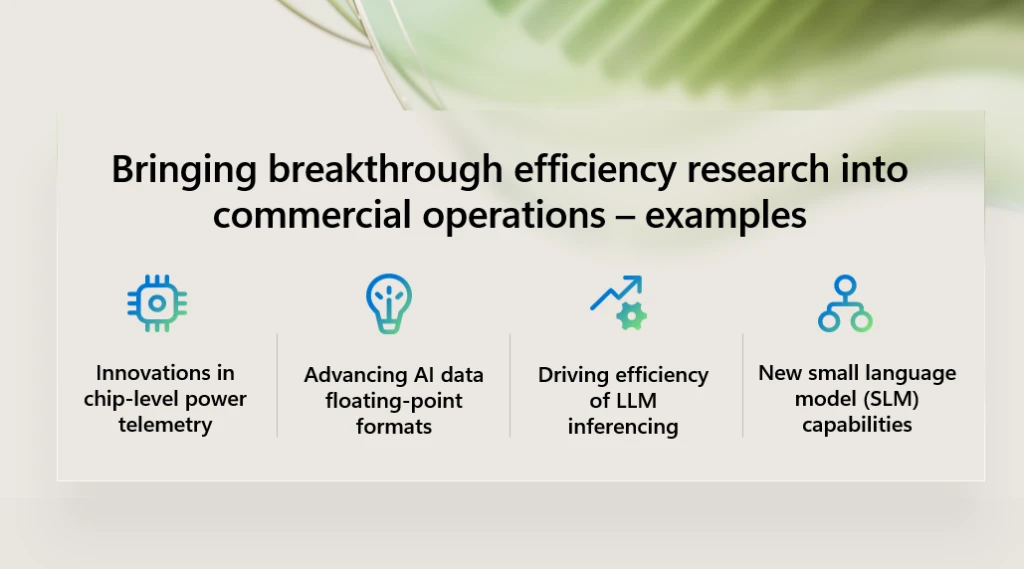

От центров обработки данных до серверов и микросхем, а также кода, алгоритмов и моделей, повышение эффективности гипермасштабируемого облака и системы инфраструктуры искусственного интеллекта сводится к оптимизации эффективности каждой части системы и того, как система работает в целом. За прошедшие годы наши исследовательские группы добились многих успехов в области повышения эффективности, поскольку мы стремимся исследовать новые смелые идеи и вносить вклад в мировое исследовательское сообщество. В этом блоге я хотел бы поделиться несколькими примерами того, как мы переносим многообещающие исследования эффективности из лаборатории в коммерческую деятельность.

Телеметрия мощности на уровне микросхем для получения точных данных об использовании в режиме реального времени.

Мы добились прорыва в обеспечении телеметрии электропитания до уровня кремния, обеспечивая новый уровень точности управления электропитанием. Для телеметрии мощности на чипе используется встроенное ПО, которое помогает нам понять профиль мощности рабочей нагрузки, сохраняя при этом конфиденциальность рабочей нагрузки и данных клиента. Это информирует программное обеспечение управления, которое предоставляет услуги управления воздушным движением в центре обработки данных, распределяя рабочие нагрузки на наиболее подходящие серверы, процессоры и ресурсы хранения для оптимизации эффективности.

Совместная работа над развитием отраслевых стандартов для форматов данных ИИ.

Внутри кремния алгоритмы работают над решением проблем, беря некоторые входные данные, обрабатывая эти данные посредством ряда определенных шагов и выдавая результат. Большие языковые модели (LLM) обучаются с использованием алгоритмов машинного обучения, которые обрабатывают огромные объемы данных для изучения шаблонов, отношений и структур языка.

Упрощенный пример от Microsoft Copilot: Представьте, что вы учите ребенка писать рассказы. Алгоритмы обучения подобны урокам и упражнениям, которые вы даете ребенку. Архитектура модели — это мозг ребенка, структурированный так, чтобы понимать и создавать истории. Алгоритмы вывода — это мыслительный процесс ребенка при написании нового рассказа, а алгоритмы оценки — это оценки или отзывы, которые вы даете, чтобы улучшить его письмо.1

Один из способов оптимизации алгоритмов для повышения эффективности — сузить точность форматов данных с плавающей запятой, которые представляют собой специализированные числовые представления, используемые для эффективной обработки действительных чисел. Работая над проектом Open Compute Project, мы сотрудничали с другими лидерами отрасли, чтобы сформировать Альянс микромасштабируемых форматов (MX) с целью создания и стандартизации 6- и 4-битных типов данных следующего поколения для обучения и вывода ИИ.

Более узкие форматы позволяют кремнию выполнять более эффективные вычисления искусственного интеллекта за такт, что ускоряет обучение модели и время вывода. Эти модели занимают меньше места, а это значит, что им требуется меньше выборок данных из памяти, и они могут работать с более высокой производительностью и эффективностью. Кроме того, при использовании меньшего количества битов по межсоединению передается меньше данных, что может повысить производительность приложений или сократить сетевые расходы.

Повышение эффективности вывода LLM за счет разделения фазы

Исследования также показывают перспективность новых подходов к выводу моделей большого языка (LLM), по существу разделяя две фазы вывода LLM на отдельные машины, каждая из которых хорошо подходит для этой конкретной фазы. Учитывая различия в потребностях фаз в ресурсах, некоторые машины могут замедлить работу своих ускорителей искусственного интеллекта или даже использовать ускорители предыдущего поколения. По сравнению с существующими конструкциями этот метод может обеспечить в 2,35 раза большую пропускную способность при тех же затратах мощности и стоимости.2

Узнайте больше и изучите ресурсы для повышения эффективности ИИ

Помимо переосмысления наших собственных операций, мы работаем над тем, чтобы дать разработчикам и специалистам по данным возможность создавать и оптимизировать модели ИИ, которые могут достигать аналогичных результатов, требуя при этом меньше ресурсов. Как упоминалось ранее, малые языковые модели (SLM) могут обеспечить более эффективную альтернативу большим языковым моделям (LLM) для многих случаев использования, таких как точная настройка экспериментов над различными задачами или даже математические задачи в начальной школе.

В апреле 2024 г. мы анонсировали Фи-3семейство открытых, высокофункциональных и экономичных SLM, которые превосходят модели того же и большего размера в различных языковых, логических, программных и математических тестах. Этот выпуск расширяет выбор высококачественных моделей для клиентов, предлагая практический выбор для создания и создания генеративных приложений искусственного интеллекта. Затем мы представили новые модели семейства Phiвключая Phi-3.5-MoE, модель «Смесь экспертов», объединяющую 16 меньших экспертов в одного, и Phi-35-mini. Обе эти модели многоязычны и поддерживают более 20 языков.

Узнайте больше о том, как мы продвигаем устойчивое развитие, из нашей серии блогов Sustainable by design, начиная с Устойчивость по замыслу: повышение устойчивости ИИ.

1Отрывок из запроса второго пилота: пожалуйста, объясните, как алгоритмы связаны с LLM.

2Разделение: эффективный генеративный вывод LLM с использованием разделения фаз, Microsoft Research.

.jpg)